navis

Video Upscaling (StableSR) 본문

728x90

1. 목차

- 환경설정

- 모델 - StableSR

- 추론 결과

- 결과 비교

- 최종 결과

2. 환경 설정

- AI 모델 테스트 환경

- Ubuntu 22.04(워크스테이션)

- Anaconda

- VS Code

- Python 3.9

- PyTorch 1.13.1

- CUDA 11.7

- 환경설정

git clone <https://github.com/IceClear/StableSR.git>

cd StableSR

conda env create --file environment.yaml

conda activate stablesr

conda install xformers -c xformers/label/dev

pip install -e git+https://github.com/CompVis/taming-transformers.git@master#egg=taming-transformers

pip install -e git+https://github.com/openai/CLIP.git@main#egg=clip

pip install -e .

git clone <https://github.com/CompVis/latent-diffusion.git>

cd latent-diffusion

pip install -e .

3. StableSR

https://github.com/IceClear/StableSR

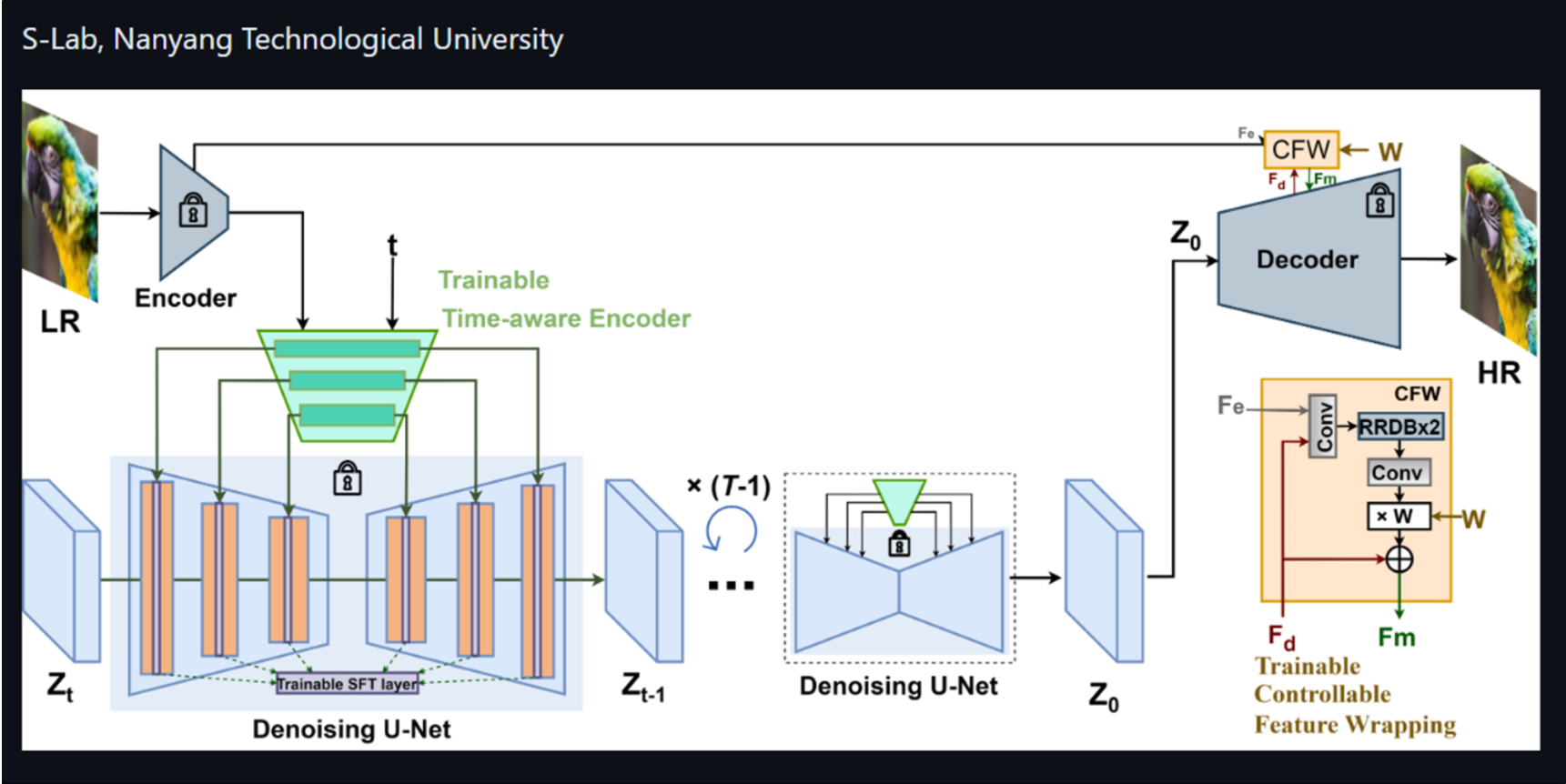

1. 모델 (StableSR)

4. 코드 변경

스크립트

python scripts/sr_val_ddpm_text_T_vqganfin_old.py \\

--config configs/stableSRNew/v2-finetune_text_T_512.yaml \\

--ckpt ./stablesr_turbo.ckpt \\

--init-img inputs/test \\

--outdir output \\

--ddpm_steps 4 \\

--dec_w 0.5 \\

--seed 42 \\

--n_samples 1 \\

--vqgan_ckpt ./vqgan_cfw_00011.ckpt \\

--colorfix_type wavelet

5. 추론 결과

input Video Frame (StableSR)

output Video Frame (StableSR)

6. 최종 결과

config를 v2-finetune_text_T_512.yaml로 밖에 사용을 할 수 없어서 512 x 512로 결과가 나오기 때문에 원본의 비율을 무시합니다.

하지만 내부 파일 조정하면 v2-finetune_text_T_768v.yaml도 사용 가능 할 것으로 보입니다.

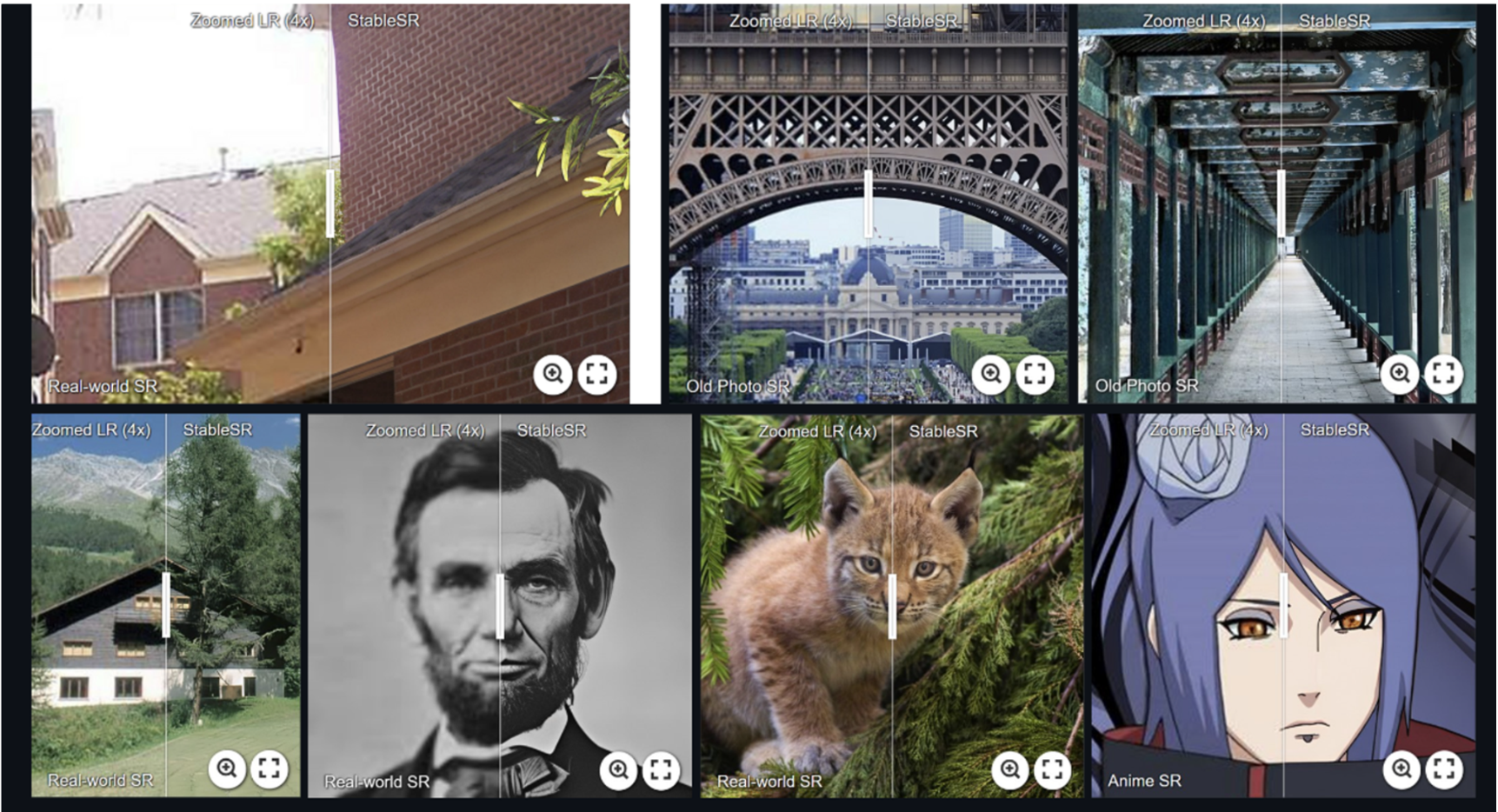

첫 번째와 두 번째 이미지처럼 얼굴이 클로즈업 되어 있다면 개선 정도가 좋으나 아래 두 이미지처럼 조금만 멀어져도 얼굴 부분이 일그러 집니다.

다른 부분에 대한 복원은 잘 되었지만 Stable 기반이여서 Video의 Frame간의 일관성은 유지 되기 어려웠습니다.

아래의 영상과 같이 글씨 부분과 나무의 결이 생성되는 과정에서 일관성을 유지하지 못해서 튀는 현상이 보였습니다.

이니 ESRGAN 모델과 비슷하지만 결과는 더 못한 것으로 보입니다.

하지만 최신 버전임에 틀림없고 내부 설정을 잡는다면 가능성도 있어 보입니다.

결과적으로는 Video에는 사용 하지 못 할 것으로 보이고 이미지 개선에 사용 되지 않을까 하고 생각 됩니다.

'AI' 카테고리의 다른 글

| Object Separation (GVTO) (0) | 2024.06.16 |

|---|---|

| Video Upscaling (ResShift) (0) | 2024.06.16 |

| Object Separation (VITON-HD) (0) | 2024.05.27 |

| 우분투 Anaconda Navigator 설치 및 실행 (0) | 2024.05.23 |

| Video Upscaling (CodeFormer) (0) | 2024.05.22 |